Les Large Language Models (LLM), comme GPT, Gemini ou Claude, sont essentiels dans l’avancement de l’intelligence artificielle (IA) pour le traitement du langage naturel. Cependant, malgré leur puissance, ces modèles ont une limite importante : leurs halucinations réguliéres et leurs données d’entraînement statiques. C’est ici qu’intervient le RAG (Retrieval-Augmented Generation). Cette technique permet de surmonter cette limite en accédant à des informations actualisées, enrichissant ainsi les performances des LLM avec des données de qualités.

Si vous voulez en savoir plus sur les LLM avant de continuer, vous pouvez aller voir nos 2 articles dédiés sur le sujet : Comprendre les LLM : Modèles de Langage IA et leur Fonctionnement & Comprendre les LLM : La puissance cachée des modèles de langage

Qu’est-ce que le RAG (Retrieval-Augmented Generation) ?

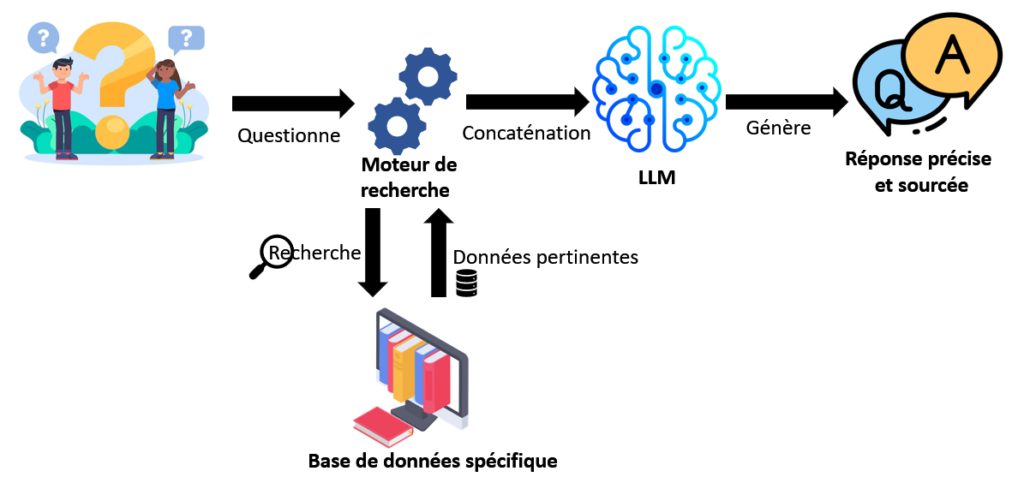

Le Retrieval-Augmented Generation (RAG) combine deux techniques : la recherche d’informations et la génération de texte. En utilisant cette approche, les LLM peuvent accéder à des informations externes en temps réel. Cela leur permet de fournir des réponses plus pertinentes et précises. Contrairement aux LLM traditionnels, qui se basent uniquement sur des données mémorisées, le RAG permet de puiser dans des sources externes actualisées avant de générer une réponse.

Fonctionnement du RAG pour les LLM

Le RAG se décompose en deux étapes principales :

- Recherche d’informations (Retrieval)

Lorsqu’une requête est soumise, le modèle recherche des informations pertinentes dans une base de données externe. Ce processus s’appuie sur des techniques de recherche sémantique pour identifier les documents ou passages les plus adaptés à la question posée. - Génération de texte (Generation)

Une fois les informations récupérées, le modèle utilise ces données pour générer une réponse. Cela permet d’améliorer la précision et la pertinence des réponses en s’appuyant sur des informations actuelles et contextuelles.

Avantages du RAG pour les LLM et l’intelligence artificielle

Le RAG améliore considérablement les capacités des LLM. Voici pourquoi cette approche est devenue incontournable :

- Accès à des données dynamiques et à jour

Les LLM traditionnels sont limités par leurs données statiques. Le RAG permet de pallier ce problème en accédant à des informations récentes, indispensables dans des domaines comme la finance, la santé ou les actualités. - Réponses plus précises et spécifiques

En combinant la génération de texte avec la recherche d’informations, le RAG offre des réponses plus pertinentes. En effet, le modèle peut s’appuyer sur des données spécifiques plutôt que sur des connaissances générales. - Personnalisation des réponses

Grâce au RAG, il est possible d’entraîner les LLM sur des bases de données internes spécifiques à une entreprise. Par conséquent, cela permet de fournir un support client plus personnalisé ou d’améliorer les recommandations produits. - Meilleure gestion des limites de mémoire

Les LLM traditionnels ont des limites en termes de mémoire contextuelle. Cela signifie qu’ils peuvent oublier des parties d’une conversation passée. Le RAG compense cette lacune en récupérant des informations externes, permettant ainsi de traiter des données oubliées ou non stockées dans le modèle.

Applications du RAG dans différents secteurs

Le RAG trouve des applications dans de nombreux secteurs, notamment :

- Service client : Les chatbots utilisant le RAG peuvent accéder à des bases de données et fournir des réponses actualisées et précises. Cela améliore l’expérience utilisateur en répondant aux questions spécifiques des clients.

- Recherche académique : Les chercheurs peuvent utiliser le RAG pour obtenir des analyses et des résumés plus détaillés à partir de bases de données spécialisées.

- Finance : Le RAG permet d’obtenir des informations financières en temps réel, ce qui est crucial pour des analyses et des prévisions basées sur des données actualisées.

- Médical : Le RAG peut aider les professionnels de la santé à accéder à des bases de données médicales actualisées pour fournir des informations récentes sur des traitements ou des diagnostics.

Les exemples ne manquent pas sur l’utilisation du RAG, chaque entreprise et chaque secteur a ses besoins spécifiques.

Cas d’utilisation du RAG pour le support technique

Prenons l’exemple du support technique. Un chatbot traditionnel basé sur un modèle LLM pourrait répondre à des questions courantes mais serait limité pour répondre aux demandes concernant des produits récemment mis à jour. Cependant, en intégrant le RAG, le chatbot peut rechercher dans une base de données technique interne et fournir des réponses précises en temps réel.

Par exemple, lorsqu’un client pose une question sur une fonctionnalité récemment mise à jour, le chatbot RAG peut accéder aux informations les plus récentes et donner une réponse adaptée. Cela améliore la satisfaction client et la précision du service offert.

Conclusion : L’avenir des LLM grâce au RAG

Le Retrieval-Augmented Generation (RAG) représente une avancée majeure pour les LLM, leur permettant de surmonter leurs limites. Grâce au RAG, les LLM peuvent accéder à des informations externes et actualisées, ce qui améliore considérablement la pertinence et la précision des réponses. Que ce soit pour offrir un meilleur support client, personnaliser les réponses ou accéder à des informations critiques en temps réel, le RAG est un outil incontournable.

À l’avenir, il est probable que de plus en plus d’applications intégreront le RAG, permettant ainsi aux entreprises de tirer pleinement parti des avancées en intelligence artificielle et en traitement du langage naturel.