Les récents incidents impliquant les fuites de Sora, le générateur vidéo d’OpenAI, et le modèle avancé “miqu-1-70b” de Mistral AI ont mis en lumière les vulnérabilités de l’industrie de l’intelligence artificielle. Ces événements, bien que différents dans leur nature, révèlent des problématiques communes concernant la sécurité des modèles d’IA et la gestion des accès anticipés. Cet article explore ces deux fuites en parallèle, en examinant leurs origines, implications et enseignements pour le secteur.

Introduction aux Fuites de Sora et Mistral AI

Sora et Mistral AI représentent deux avancées technologiques majeures dans le domaine de l’intelligence artificielle. Sora, développé par OpenAI, est un générateur de vidéos capable de produire des contenus visuels impressionnants. À l’inverse, Mistral, une jeune entreprise européenne, s’est distinguée par ses modèles de langage avancés, notamment le modèle “miqu-1-70b”.

Ces modèles sont des trésors technologiques pour leurs développeurs, mais leur fuite non autorisée a révélé des failles importantes dans la gestion de leur accès et de leur sécurité.

Origines des Fuites : Qui est Responsable ?

Sora : Une API Piratée par des Artistes Mécontents

La fuite de Sora a été attribuée à un groupe d’artistes ayant eu un accès anticipé au modèle. Ces artistes, insatisfaits de certaines décisions ou pratiques d’OpenAI, auraient détourné leur accès pour diffuser illégalement le générateur vidéo via une API piratée.

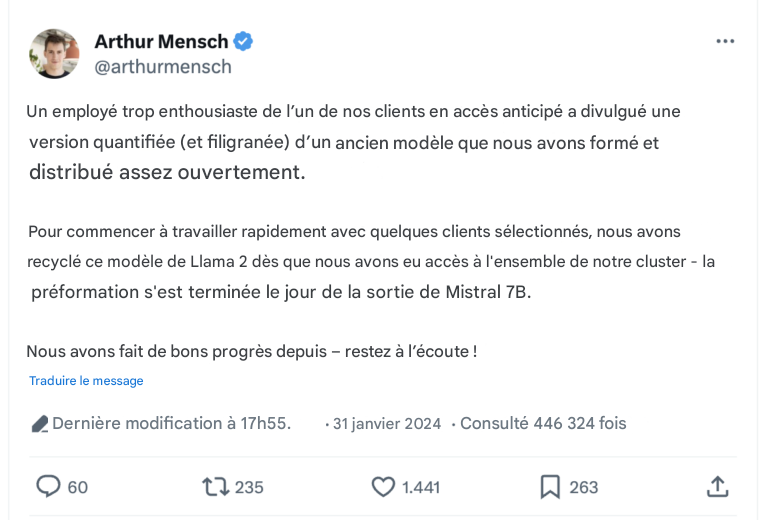

Mistral : Un Employé Trop Enthousiaste

Dans le cas de Mistral, le modèle “miqu-1-70b” a été divulgué sur des plateformes comme HuggingFace et 4chan. Cette fuite semble provenir d’un client en accès anticipé, où un employé, manifestement peu conscient des conséquences, aurait partagé le modèle publiquement.

Ces deux incidents soulignent le besoin critique de gérer rigoureusement les accès et les responsabilités des testeurs.

Performances des Modèles Fuités

Sora : Génération Vidéo de Haute Qualité

Les vidéos générées par Sora ont impressionné les observateurs par leur fluidité et leur réalisme. Ces performances confirment la position d’OpenAI en tant que leader dans la création de contenus visuels basés sur l’IA.

Mistral : Des Résultats qui Surpassent les Attentes

Le modèle Mistral, malgré sa fuite, a démontré des capacités exceptionnelles, surpassant même certains des modèles précédemment dévoilés par l’entreprise. Cela a attiré l’attention de nombreux experts de l’IA, amplifiant involontairement la visibilité de Mistral.

Réactions des Entreprises

OpenAI : Une Gestion Rapide et Rigoureuse

Face à la fuite, OpenAI a désactivé rapidement l’accès à l’API concernée, limitant ainsi la propagation non autorisée de Sora. Cette réponse immédiate a montré l’importance d’un système de surveillance efficace.

Mistral : Une Approche Plus Décontractée

À l’inverse, Mistral a adopté une approche plus détendue. Le PDG de l’entreprise a même plaisanté sur la situation, ce qui a intrigué la communauté tech. Cette réponse, bien que non conventionnelle, reflète peut-être une stratégie visant à minimiser l’impact négatif sur leur image.

Conséquences pour l’Industrie de l’IA

Les fuites de Sora et de Mistral soulèvent plusieurs questions critiques pour l’industrie :

- Sécurité des Modèles

- Les protocoles actuels de protection des données sont-ils suffisants ?

- Éthique et Collaboration

- Comment collaborer en toute sécurité avec des testeurs et partenaires externes ?

- Diffusion Non Contrôlée de l’IA

- Quels sont les risques si des technologies avancées tombent entre de mauvaises mains ?

Comparaison des Fuites : Similitudes et Différences

| Aspect | Sora (OpenAI) | Mistral (Mistral AI) |

|---|---|---|

| Origine | Artistes mécontents | Employé d’un client |

| Type de fuite | API piratée | Modèle téléchargé et partagé |

| Réaction | Désactivation immédiate | Réponse humoristique |

| Impact | Menace concurrentielle | Visibilité accrue involontaire |

Enseignements pour les Acteurs de l’IA

Les incidents Sora et Mistral offrent des leçons cruciales pour l’industrie :

- Renforcement des Protocoles de Sécurité

- Adopter des systèmes avancés pour surveiller les accès et détecter les comportements suspects.

- Formation et Sensibilisation

- Éduquer les partenaires et employés sur les conséquences des fuites.

- Collaboration Responsable

- Développer des contrats clairs pour responsabiliser les testeurs en accès anticipé.

Prévention des Fuites Futures : Solutions et Innovations

Les entreprises pourraient adopter des solutions innovantes telles que :

- Systèmes de Gestion des Accès Dynamiques : Limiter l’accès aux modèles selon les besoins spécifiques.

- Suivi de l’Utilisation des Modèles : Intégrer des mécanismes pour tracer l’origine des fuites.

- Cryptage Avancé des Modèles : Protéger les données même en cas de téléchargement non autorisé.

Conclusion : Sécuriser l’Avenir des Modèles d’IA

Les fuites de Sora et Mistral sont des rappels alarmants de la vulnérabilité des technologies avancées. Pour évoluer dans un domaine aussi compétitif que l’IA, les entreprises doivent renforcer leur sécurité, responsabiliser leurs partenaires et anticiper les menaces potentielles.

Boostez vos Projets IA avec Edgework

Les cas Sora et Mistral montrent à quel point l’intelligence artificielle est au cœur des enjeux stratégiques modernes. Chez Edgework, nous transformons vos idées en solutions IA concrètes et performantes. Que ce soit pour automatiser vos processus, améliorer vos interactions clients ou créer des outils sur mesure, notre expertise vous accompagne à chaque étape. Faites passer votre entreprise à la vitesse supérieure avec nos services IA : découvrez-en plus sur edgework.fr.