Cet article fait partie de la série Comprendre les LLM retrouvable ici.

Décryptage d’une technique clé de l’IA

L’intelligence artificielle progresse à pas de géant, révolutionnant de nombreux secteurs. Parmi les techniques au cœur de cette révolution figure le fine-tuning, un processus qui permet d’adapter des modèles d’apprentissage automatique pré-entraînés à des tâches spécifiques. Cet article démystifie le fine-tuning, explorant son fonctionnement, ses applications et ses limites.

Qu’est-ce que le fine-tuning ?

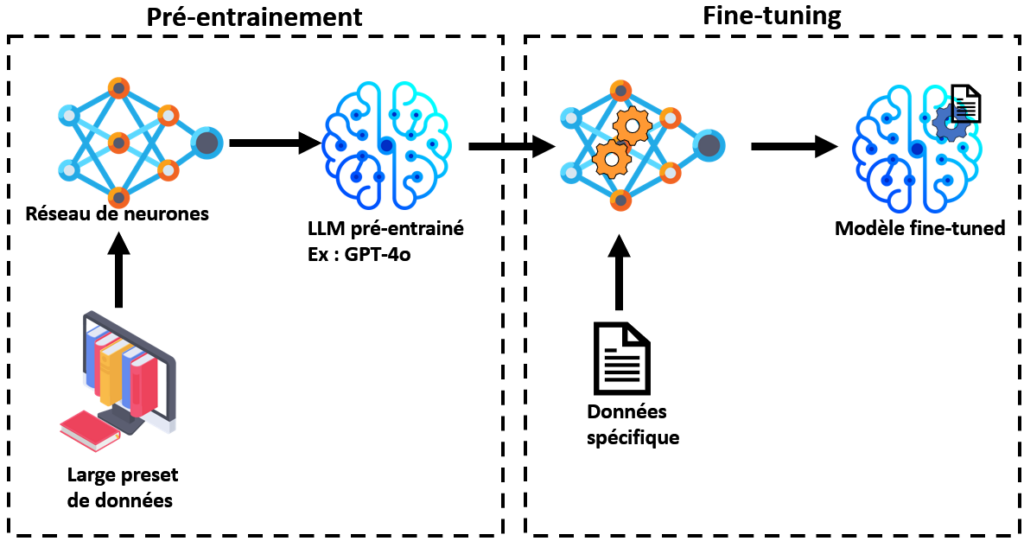

Il consiste à prendre un modèle d’apprentissage automatique, tel qu’un LLM (ex : GPT-4o ou Gemini), qui a été pré-entraîné sur un vaste ensemble de données générales, et à l’affiner pour une tâche ou un domaine particulier. Ce processus est comparable à la formation spécialisée d’un étudiant brillant pour exceller dans un domaine spécifique.

Par exemple, un modèle pré-entraîné sur Wikipédia peut être affiné pour :

- La traduction automatique : entraînement sur des paires de phrases traduites.

- L’analyse des sentiments : entraînement sur des critiques étiquetées positives ou négatives.

- La reconnaissance d’entités nommées : entraînement à identifier des personnes, des organisations ou des lieux dans un texte.

Le processus de fine-tuning

Le procédé se déroule généralement en trois étapes:

- Définition de la tâche ou du domaine : Déterminer l’objectif précis du modèle, par exemple détecter les fraudes financières ou traduire des documents médicaux.

- Collecte et préparation des données : Rassembler des données spécifiques à la tâche, comme des rapports financiers ou des conversations de chatbots. La qualité et la quantité des données sont cruciales.

- Ajustement du modèle : Modifier certains paramètres du modèle pré-entraîné et l’entraîner sur les nouvelles données pour optimiser ses performances.

Applications en entreprise

Le fine-tuning a de nombreuses applications concrètes en entreprise. Par exemple, Bloomberg a développé BloombergGPT, un LLM spécialisé dans la finance. Entraîné sur des données financières massives, il est utilisé pour des tâches comme la prédiction des tendances du marché et l’analyse des sentiments.

D’autres exemples d’utilisation en entreprise :

- Automatisation du traitement des demandes d’assurance.

- Personnalisation des recommandations de produits.

- Détection des spams et des contenus inappropriés.

- Amélioration de la précision des diagnostics médicaux.

Défis et limites du fine-tuning

Malgré son potentiel, il présente des défis et des limites :

- Surajustement : Si le modèle est trop spécialisé sur les données d’entraînement, il peut ne pas bien généraliser à de nouvelles données.

- Coût et complexité : Le fine-tuning peut nécessiter des ressources informatiques importantes et une expertise technique pointue.

- Qualité des données : La performance dépend fortement de la qualité et de la pertinence des données utilisées. Des données biaisées ou incomplètes peuvent entraîner un modèle peu performant.

Les avancés

La recherche sur le fine-tuning se concentre sur l’amélioration de son efficacité, de sa robustesse et de sa flexibilité. De nouvelles techniques sont explorées, notamment :

- Apprentissage par transfert : modification d’une petite partie des paramètres du modèle pour réduire les coûts et la complexité.

- Optimisation des hyperparamètres : réglage des paramètres qui contrôlent le processus d’apprentissage.

- Adaptation aux données multimodales : combinaison de texte, d’images et de sons pour des modèles plus riches et plus performants.

Pour aller plus loin

Si le sujet vous intéresse, je vous conseille vivement d’explorer Hugging Face. Véritable mine d’or, cette plateforme propose des milliers de modèles pré-entraînés ainsi qu’une multitude de datasets pour démarrer ou approfondir vos projets.

Nous avons ici principalement parlé des LLM, c’est-à-dire des modèles text-to-text. Mais il existe aussi d’autres types de modèles fascinants, comme :

- Les text-to-image, qui génèrent des images à partir de descriptions textuelles.

- Les voice-to-voice, disponibles dans les dernières versions de ChatGPT, qui permettent de traiter l’audio plus rapidement et efficacement.

Vous pouvez retrouver le podcast généré par IA ici (en anglais) :

Conclusion

Le fine-tuning est une technique puissante qui permet d’adapter les modèles d’IA à des tâches spécifiques. Son utilisation croissante dans divers secteurs témoigne de son potentiel à révolutionner notre façon de travailler et d’interagir avec le monde. Cependant, il est essentiel de comprendre ses limites et de poursuivre la recherche pour améliorer ses performances et son accessibilité.

Et vous, avez-vous déjà utilisé des modèles fine-tunés dans vos projets ? Quels sont les défis ou réussites que vous avez rencontrés ? Partagez votre expérience dans les commentaires !